La Inteligencia Artificial es una herramienta profundamente disruptiva para las trabajadoras y los trabajadores del conocimiento. Para utilizarla con éxito y, sobre todo, con criterio, merece la pena invertir tiempo en comprenderla más allá de un uso meramente instrumental como usuarios.

He leído numerosos artículos y he visto muchos vídeos sobre el funcionamiento interno de la IA, sobre sus tripas. Uno de los contenidos más didácticos con los que me he encontrado recientemente es una ponencia del médico y catedrático Juan José Beunza Nuin en el marco de la I Jornada Científica de Medicina Digital, celebrada en diciembre de 2025 en Pontevedra (España).

El doctor Juan José Beunza Nuin es una voz autorizada en la aplicación de la IA en entornos sanitarios: director del grupo de trabajo IASalud-UEM y editor y autor principal del Manual Práctico de Inteligencia Artificial en Entornos Sanitarios (Elsevier, 2020; segunda edición en 2023). La ponencia a la que me refiero puede verse completa en YouTube.

Durante los primeros minutos de la charla explica de forma muy clara y accesible qué es un LLM (Large Language Model) o modelo extenso de lenguaje, es decir, lo que son ChatGPT, Gemini, Copilot, DeepSeek, Claude, Grok, etc. Como ocurre en toda explicación dirigida a un público amplio sobre una tecnología compleja, el ponente introduce algunas simplificaciones. Aun así, considero que expone con gran claridad las bases de la tecnología subyacente a un LLM.

En este artículo incorporaré, además, alguna simplificación adicional de cosecha propia, con el objetivo de quedarnos con la esencia de cómo funcionan estos modelos.

El nacimiento de la arquitectura Transformer

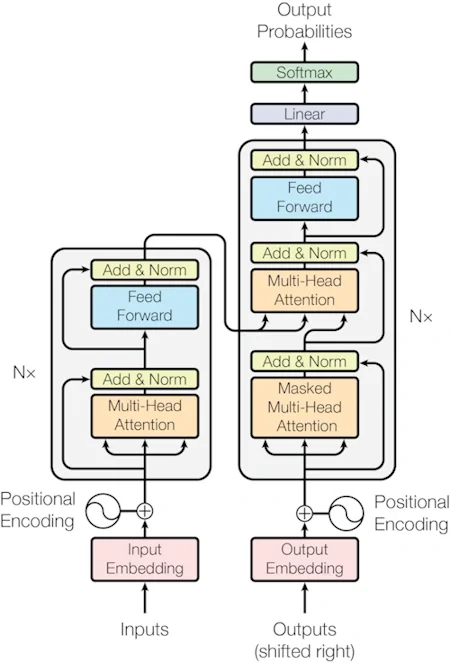

En 2017, ocho autores que trabajaban en Google publicaron el artículo científico Attention is All You Need, en el que se introdujo una nueva arquitectura de red neuronal denominada Transformer. Este trabajo supuso un auténtico cambio de paradigma.

Los investigadores de Google propusieron la arquitectura Transformer en un contexto muy ligado a la traducción automática (Google Translate). Sin embargo, fue OpenAI quien dio el siguiente paso al convertir esta arquitectura en un modelo generativo de lenguaje, creando GPT en 2018.

Cómo genera texto un LLM

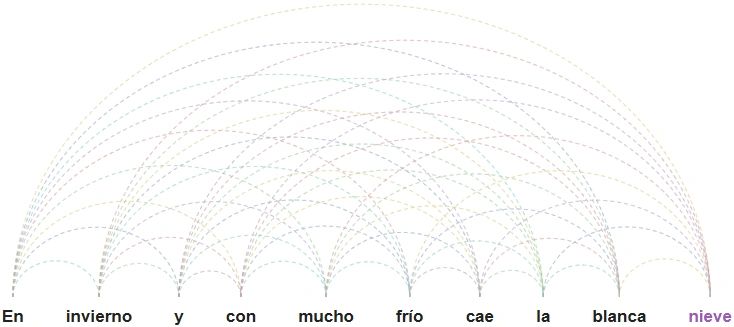

Gracias a la arquitectura Transformer, cuando un modelo está generando texto es capaz de tener en cuenta todas las palabras anteriores de la frase antes de proponer la siguiente.

En la frase:

"En invierno y con mucho frío cae la blanca → ?"

el modelo tiene en cuenta simultáneamente “invierno”, “mucho”, “frío” y “blanca”, relacionándolas entre sí para predecir matemáticamente la siguiente palabra. En este caso, la predicción correcta será “blanca → nieve”, y no, por ejemplo, “blanca → camiseta”, “blanca → harina” o “blanca → nube”. Al considerar todas las palabras previas a la vez, la probabilidad de acierto aumenta de forma significativa.

Ahora bien, simplificando mucho, todo es una cuestión de probabilidades y matemáticas. El LLM no piensa, no entiende lo que dice y no sabe si lo que genera es verdadero o falso.

Al conjunto de palabras que el modelo tiene en cuenta para predecir la siguiente palabra de la secuencia se le denomina contexto.

Por eso habrás observado que, cuando utilizas ChatGPT durante sesiones muy largas, la calidad puede resentirse. A veces ocurre porque la conversación se acerca a los límites de su ventana de contexto (y parte de lo anterior deja de “caber”); otras veces, simplemente, porque en un contexto muy extenso es más difícil priorizar lo relevante. De ahí que se hable de modelos con ventanas de contexto más grandes que otros.

Cómo funciona un Transformer

Veamos ahora, con algo más de detalle —aunque de forma necesariamente simplificada—, cómo funciona un Transformer.

Un Transformer no trabaja directamente con palabras, sino con tokens. Conviene mencionarlos porque seguramente hayas oído hablar de ellos. Un token puede corresponderse con una palabra completa, pero también con una parte de una palabra. Para simplificar esta explicación, asumiremos que una palabra equivale a un token y hablaremos de “palabras” para facilitar la comprensión.

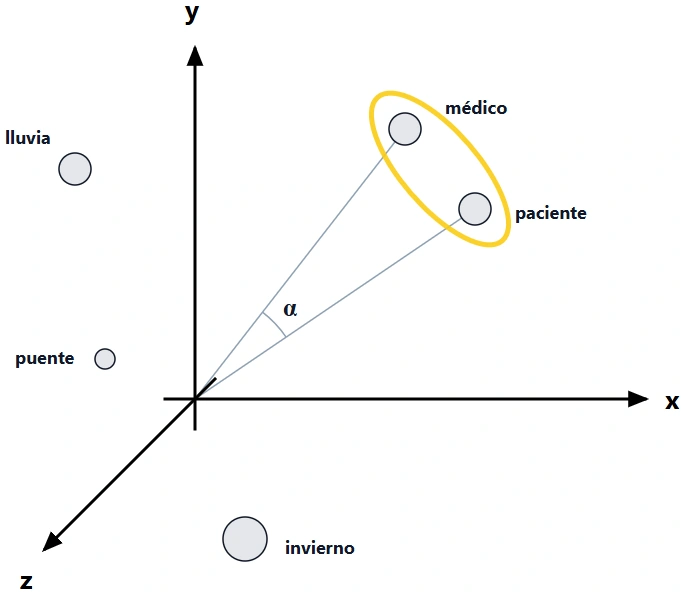

Un Transformer convierte las palabras en números, más concretamente en vectores. Por ejemplo, la palabra médico podría estar definida por un vector de tres dimensiones como (6, 8, 1), y la palabra paciente por el vector (8, 6, 1).

Todas las palabras se representan en un espacio matemático. Las palabras conceptualmente cercanas —como médico y paciente— tienen entre sí un ángulo menor que palabras menos relacionadas, como paciente e invierno. Los conceptos cercanos tienden a quedar “próximos” en ese espacio. Lo que hace un LLM, simplificando mucho, es calcular estas distancias entre las palabras y, a partir de ahí, construir su respuesta.

En este ejemplo simplificado solo hemos utilizado tres dimensiones. En la realidad, los modelos extensos de lenguaje (LLM) se entrenan con billones de palabras y trabajan en un espacio multidimensional que suele tener en torno a 12.000 dimensiones. Es decir, cada palabra está representada por un vector formado por miles de números.

Tal y como yo lo entiendo, cuando un LLM genera una respuesta aplica una capacidad de cálculo enorme sobre este gigantesco espacio multidimensional de palabras.

Limitaciones de los LLM

Los modelos generativos de lenguaje —como ChatGPT o Gemini— no son los únicos tipos de Transformers que existen. Hay otros, que darían para otro artículo y que quizá aborde en el futuro. Los LLM están especializados en generar texto y lo hacen, como hemos visto, mediante un mecanismo de relaciones asociativas basadas en probabilidad. Por este motivo, lo que generan no tiene por qué ser verdadero. No es su propósito ni el objetivo para el que fueron diseñados.

Cuando un modelo ha sido entrenado con información verídica y aquello por lo que le preguntamos se encuentra dentro de sus datos de entrenamiento, aumenta la probabilidad de que responda correctamente (aunque no es una garantía). Si no es así, puede inventar una respuesta. Y lo hará de una forma que suena muy verosímil y convincente. A este fenómeno se le ha denominado “alucinación” de la IA.

A día de hoy —y sin saber si esto cambiará en el futuro— los LLM fallan. No son sistemas 100 % fiables. Por eso requieren una supervisión humana constante y con criterio.

Tal y como explica Juan José Beunza hacia el final de su ponencia, la IA funciona especialmente bien cuando se parte de un buen profesional, con criterio, al que se forma en el uso adecuado de estas herramientas. El resultado es un súper profesional. En cambio, si se elimina por completo la supervisión humana, la IA cometerá errores que, en ámbitos como el sanitario, simplemente no son aceptables.